Qui ?

Groupe d'étudiants de l'université Claude Bernard - Lyon 1 (dans l'ordre alphabétique) :

- Areg Baghinyan

- Pierre-loup Barazzutti

- Nolan Declercq

- Aurelien Grivollat

- Romane Lhomme

- Yoann Maret-verdant

- Adam Sooga

- Cyril Veve

Quoi ?

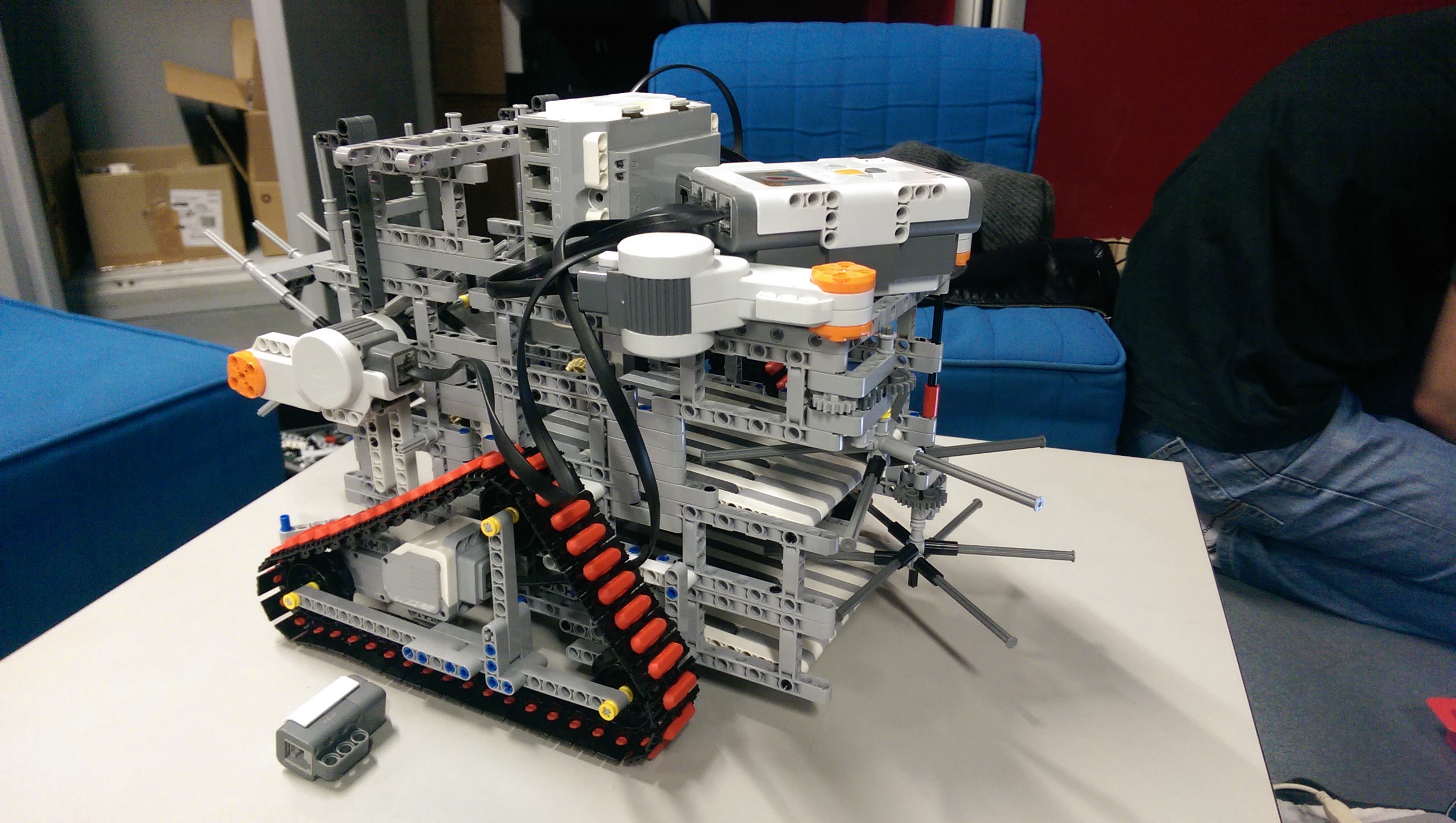

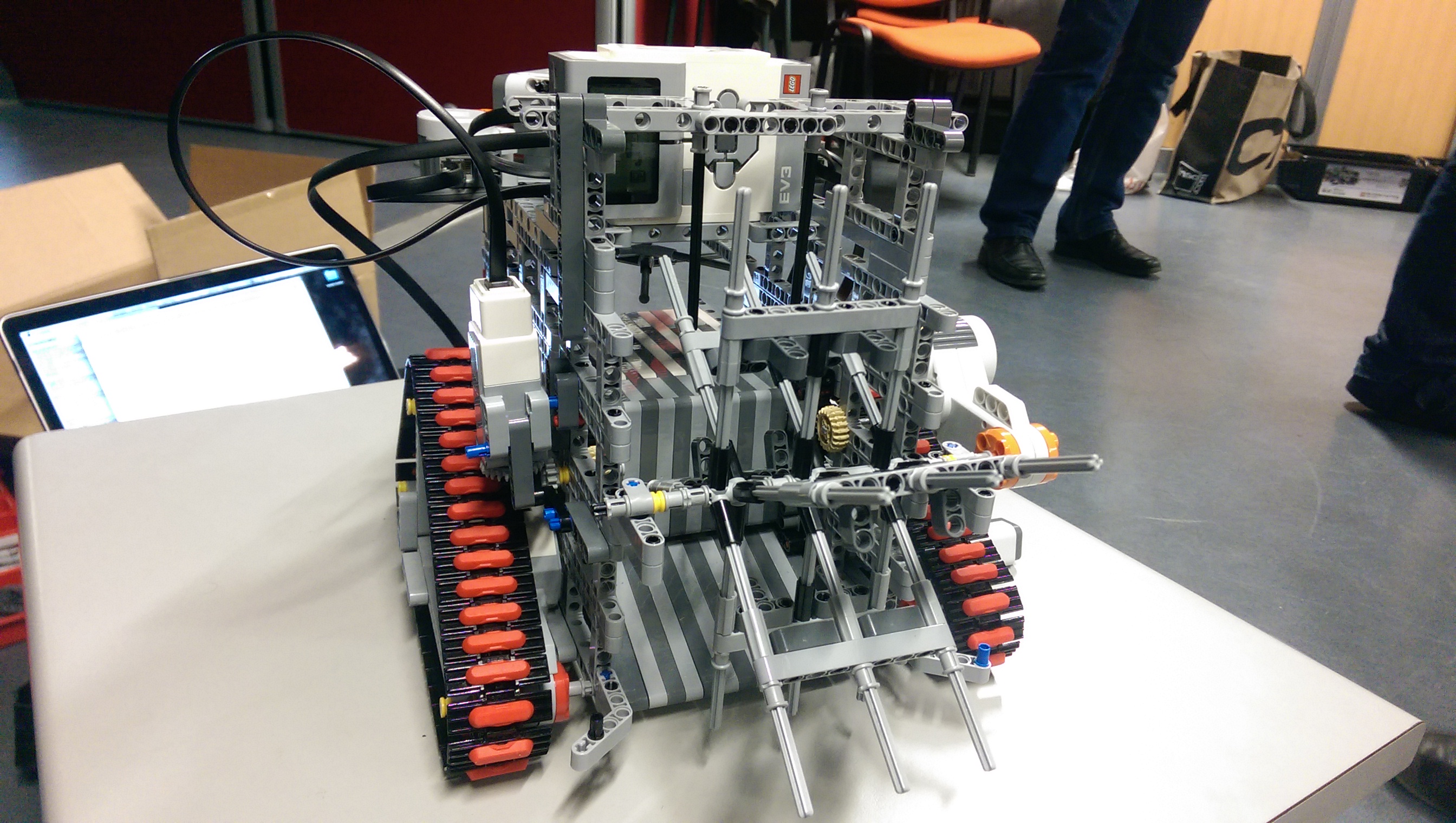

Construction d'un robot ramasseur / éjecteur de balles avec :

- Environnement inconnu (obstacles...)

- Exercices imposés (tri des balles selon couleur...)

Quand ?

Projet basé sur une semaine intensive de programmation (donc hors construction du robot) lors du second semestre de la première année du Master d'informatique.

Comment ?

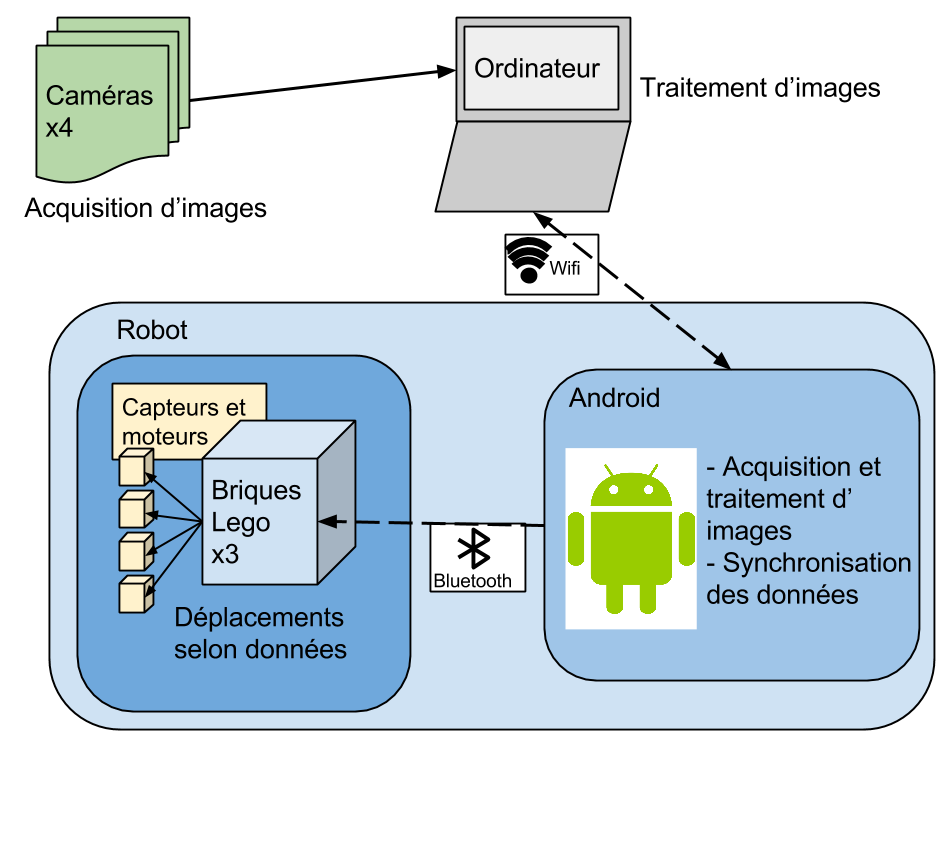

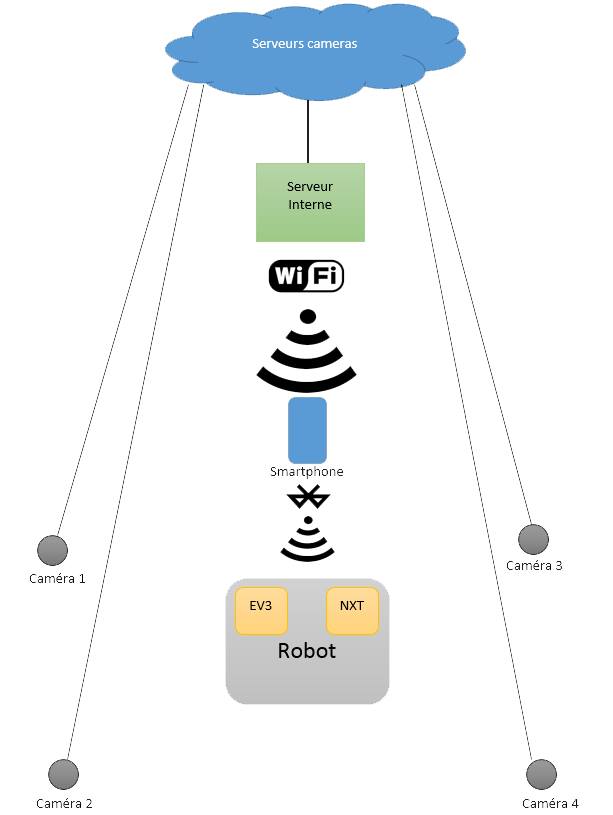

Construction du robot avec Matériel LEGO Mindstorms imposé et smartphone (Android, IOS, WindowsPhone). Accès à un réseau de caméra placées autour du terrain.

Pourquoi ?

Idée principale : Travailler en groupe.

Différentes spécialitées mises en oeuvre :

Analyse d'image (Réseau de caméras et webcam du smartphone), Intelligence artificielle (Déplacement dans le terrain), Réseau (connectivité entre les éléments)